49. Zjazd Fizyków Polskich, Katowice 2025

Wydział Humanistyczny, Uniwersytet Śląski w Katowicach

==English version below==

49 Zjazd Fizyków Polskich 2025 gościł w Katowicach. Konferencja odbyła się w dniach od piątku 5 września do czwartku 11 września 2025 włącznie. Organizatorami są Polskie Towarzystwo Fizyczne oraz Uniwersytet Śląski w Katowicach.

Harmonogram (plik pdf, wersja interaktywna, wersja szczegółowa):

- 5 września - przyjazdy i rejestracja

- Poranna uroczysta sesja 6 września odbędzie się w Filharmonii Śląskiej z udziałem gościa honorowego - laureatki Nagrody Nobla w 2023 roku, prof. Anne L'Huillier.

- Weekend 6-7 września główna tematyka - dydaktyka, działalność młodych naukowców, duże eksperymenty, konkurs na wystąpienie i poster dla studentów InnoFusion 2025

- 8-11 września - sesje tematyczne

- 7,11 września - 2 sesje wyjazdowe w Planetarium - Śląskim Parku Nauki.

==English version==

The 49th Congress of Polish Physicists was organised in 2025 in Katowice. The conference was held from Friday, 5th September, to Thursday, 11th September 2025. The organisers are the Polish Physical Society and the University of Silesia in Katowice.

Timetable (pdf file, interactive version, detailed version):

- 5th September - arrivals and registration

- the opening ceremony takes place during the morning session on Saturday, 6th September, in the Silesian Philharmonic building. The guest of honour of the conference, prof. Anne L'Huillier, who won the Nobel Prize in Physics 2023, will give a special lecture.

- the main topics covered during the weekend of 6th-7th September 2025 are physics teaching, the coverage of physical topics in mass media, the propagation of research results in popular form, the achievements of young scientists and the biggest physics centres in the world, the InnoFusion 2025 students' competition.

- from 8th September on - topical sessions

- on 7th and 11th September - 2 sessions outside of the main venue in the Planetarium - Silesian Science Park.

Projekt ">>Na pograniczu<< - nauka, muzyka, gospodarka" dofinansowany ze środków budżetu państwa, przyznanych przez Ministra Nauki w ramach Programu Społeczna odpowiedzialność nauki II.

(POPUL/SP/0532/2024/02, kwota dofinansowania 67 000 zł)

Projekt "Od Atomów do Społeczności: ogólnokrajowy konkurs dla studentów na najlepsze wystąpienie i poster z zakresu wykorzystania fizyki w różnych dyscyplinach naukowych - InnoFusion" został dofinansowany przez Górnośląsko-Zagłębiowską Metropolię w ramach Programu "Metropolitalny Fundusz Wspierania Nauki".

(RW/07/2025, kwota dofinansowania 31 320 zł, wkład własny 3 480 zł)

Adam Buczek

Adam Kubiela

Adam Maj

Adam Michczyński

Agnieszka Gawryszczak

Agnieszka Wasilkowska

Agnieszka Winiarska -Furtak

Andrzej Pelc

Andrzej Ptok

Andrzej Siodmok

Andrzej Wilczek

Andrzej Zięba

Andrzej Ślebarski

Aneta Szczygielska-Łaciak

Angelina Łobejko

Anna Kaczmarska

Anna Kaźmierczak-Bałata

Anna Krzyczkowska

Anna Musiał

Artur Bednarkiewicz

Barbara Popek

Cezary Filipiuk

Daria Babyn

Dinh Quoc Huy Pham

Dobromiła Szczepaniak

Dorota Wejer

Edward Rydygier

Elzbieta Stephan

EMRE ARKAN

Ewa Dębowska

Ewa Juszyńska-Gałązka

Ewa Kurek

Ewa Stępień

Gabriel Kuderowicz

Grzegorz Bergmański

Grzegorz Korbaś

Grzegorz M. Koczan

Grzegorz Wojewoda

Henryk Fiedorowicz

Iaroslav Shopa

Ilona Karpiel

Irena Waliduda

Ireneusz Weymann

Iwona Bronowicka

Izabela Skwira-Chalot

Izabela Suchodolska

Jacek Siódmiak

Jadwiga Horodecka

Jakub Rysz

Jakub Szlachetko

Jan Paczesny

Jan Sładkowski

Janusz Gluza

Janusz SADOWSKI

Janusz Winiecki

Jarosław Paluch

Jarosław Pawluczyk

Jerzy Bałka

Jerzy Goraus

Jerzy Jarosz

Jerzy Kubacki

Joachim Kusz

Joanna Gondek

Joanna Grecka-Otremba

Joanna Kalaga

Jolanta Prywer

Julian Sienkiewicz

Julian Srebrny

Justyna Bartol-Baszczyńska

JÓZEFINA TURŁO

Kamil Korzekwa

Karol Synoradzki

Karol Szostek

Karol Życzkowski

Katarzyna Książek

Katarzyna Nowakowska-Langier

Katarzyna Pogoda

Krzysztof Grzanka

Krzysztof Turzyński

Leszek Sirko

Ludwik Lehman

Lukasz Scheller

Maciej Ślot

Magdalena Grajek

Magdalena Matejska-Minda

Marcin Chrzaszcz

Marcin Kuźniak

Marcin Łaciak

Marcin Łobejko

Marek Rams

Maria Kmiecik

Maria Szlawska

Marzena Janiszewska

Małgorzata Pawlik-Podgórska

Małgorzata Szymaszek

Megha Mogarkar

Michal Bialobrzewski

Michalina Maszkowska

Michał Baranowski

Michał Ławniczak

Monika Gielarek

Mykola Shopa

Natalia Wendler

Nikhil Krishna

Paweł Janowski

Paweł Moskal

Paweł Zajdel

Piotr Bednarczyk

Piotr Bednarczyk

Piotr Duka

Piotr Frąckiewicz

Piotr Homola

Piotr Kaźmierczak

Piotr Kononowicz

Piotr Ludwikowski

Piotr Szymczak

Piotr Zieliński

Radosław Wnęk

Rafał Demkowicz-Dobrzański

Robert Góra

Roman Szostek

Roman Świetlik

Ryszard Horodecki

Sebastian Trojanowski

Stanisław Bednarek

Stanisław Kistryn

Stanisław Kuliberda

Sławomir Binek

Sławomir Miernicki

Tadeusz Kosztołowicz

Tadeusz Winkler

Teresa Kasprzyk-Kucewicz

Tetiana Grott

Tomasz Kubiak

Tomasz Mróz

Tomasz Toliński

Tomasz Wasiak

Tomasz Wróblewski

Tomasz Wybranowski

Urszula Dzienisiuk

Wieslaw Nowak

Wiesław Z. Polak

Witold Polesiuk

Wojciech Rudno-Rudziński

Wojciech Zając

Władimir Tomin

Yuriy Zorenko

Zbigniew Ficek

- +144

-

-

17:00

→

20:00

Początek rejestracji

-

17:00

→

20:00

-

-

08:00

→

08:30

Rejestracja - tylko plakietki Filharmonia Śląska im. Henryka Mikołaja Góreckiego

Filharmonia Śląska im. Henryka Mikołaja Góreckiego

ul. Sokolska 2, 40-084 Katowice -

09:00

→

14:00

Uroczysta sesja w Filharmonii SALA KONCERTOWA IM. KAROLA STRYJI (Filharmonia Śląska im. Henryka Mikołaja Góreckiego)

SALA KONCERTOWA IM. KAROLA STRYJI

Filharmonia Śląska im. Henryka Mikołaja Góreckiego

ul. Sokolska 2 40-084 Katowice -

09:00

→

18:00

Wystawa sponsorów i prezentacja ofert studiów dla szkół i studentów Hol

Hol

-

14:00

→

17:00

Rejestracja

-

16:00

→

16:40

Wykład popularnonaukowy (prof. Andrzej Dragan) B.1.1+B.0.38+B.0.39 (połączone)

B.1.1+B.0.38+B.0.39 (połączone)

-

17:00

→

19:00

InnoFusion: Sesja wystąpień ustnych C.0.37

C.0.37

-

17:00

→

19:00

Sesja dydaktyczna/naukowa I B.0.39

B.0.39

-

17:00

Poznawcze funkcjonowanie człowieka – jak psychologia wspiera proces uczenia się. 30m

Procesy poznawczego przetwarzania informacji mają istotne znaczenie podczas uczenia się. Znajomość rozwoju poznawczego człowieka, funkcjonowania uwagi, percepcji czy pamięci pozwala na dostosowanie metod nauczania, tym samym wspieranie wyników edukacyjnych. Integracja psychologii poznawczej z praktyką edukacyjną może zwiększać efektywność procesu nauczania, uwzględniającego naturalne zdolności i ograniczenia ludzkiego umysłu.

Speaker: Katarzyna Ślebarska (Uniwersytet Śląski w Katowicach) -

17:35

Osoba ucząca się o zróżnicowanych potrzebach rozwojowym i edukacyjnych w kształceniu nauk ścisłych w szkole ponadpodstawowej 30m

Wychodząc naprzeciw potrzebom uczniom z SPE i nauczycielom, szeroko pojmowanego środowiska oświatowego, mając zarazem na uwadze jakość edukacji wymienionych uczniów z różnymi potrzebami edukacyjnymi, Ministerstwo Edukacji Narodowej wprowadziło szereg zmian w prawie, których głównym celem jest włączenie tych uczniów do grupy rówieśniczej i zapewnienie im wszechstronnego wsparcia, z jednoczesnym wsparciem nauczycieli, specjalistów. Zasadniczą zmianą, w porównaniu z dotychczasowym funkcjonującym stanem prawnym, jest umożliwienie zróżnicowanego – oraz elastycznego i dostosowanego do różnych potrzeb uczniów ze specjalnymi potrzebami edukacyjnymi – podejścia do organizacji kształcenia i pomocy psychologiczno-pedagogicznej. Uczniowie ze specjalnymi potrzebami edukacyjnymi przejawiają różnorodne potrzeby - różnią się między sobą zarówno pod względem indywidualnych predyspozycji, stanu zdrowia, jak i możliwości intelektualnych.

Speaker: Dorota Prysak (Uniwersytet Śląski w Katowicach) -

18:10

Elementy Szczególnej Teorii Względności w pierwszej klasie liceum 20m

Podczas wystąpienia opowiem o przykładowym konspekcie lekcji wprowadzającej do zagadnień szczególnej teorii względności na poziomie liceum ogólnokształcącego. Poziom trudności jest dostosowany nie tylko dla 4 klasy, w której elementy STW stanowią temat osobnego działu, ale również dla klasy 1 jeżeli materiał ten miałby pojawić się jako uzupełnienie działów związanych z kinematyką i dynamiką. W trakcie wystąpienia przedstawię zarys wydarzeń w historii fizyki, które doprowadziły do powstania tej teorii i były motywacją do sformułowania jej w obecnie znanej nam formie. Na tej podstawie opowiem jak postulaty STW korespondują z teorią elektrodynamiki klasycznej. Następnie pokażę sposoby wyprowadzania wzorów na dylatację czasu i skrócenie Lorentza wraz z przykładowymi obliczeniami pomagającymi w zrozumieniu założeń i konsekwencji STW. Przedstawię również proste przykłady diagramów czasoprzestrzennych oraz omówię paradoks bliźniąt na ich podstawie.

Treść omawianych zagadnień została przygotowana na podstawie lekcji przeprowadzonych w klasach 1 i 2 w XLI LO im J. Lelewela w Warszawie.Speaker: Stanislaw Rakowski (University of Warsaw) -

18:35

Jak najprościej mówić o zjawisku indukcji elektromagnetycznej w szkole średniej 20m

Dla bardzo wielu uczniów pojęcie strumienia indukcji magnetycznej jest trudne do zrozumienia. Pokażę, że można wszystkie treści dotyczące powstawania i przesyłania prądów indukcyjnych, które są zapisane w podstawie programowej wyjaśnić bez pojęcia strumienia indukcji. Sprawdziłem na swoich uczniach, że takie podejście przynosi lepsze skutki niż tradycyjny opis zjawiska indukcji elektromagnetycznej.

Speaker: Grzegorz Wojewoda (VI LO Bydgoszcz)

-

17:00

-

17:00

→

19:00

Sesja dydaktyczna/naukowa II B.0.38

B.0.38

-

17:00

Sztuczna inteligencja w eksploracji nauk ścisłych 30m

Podczas wykładu przedstawię, jak na co dzień wykorzystuję sztuczną inteligencję w badaniach naukowych i pracy akademickiej, ze szczególnym uwzględnieniem analizy danych — dziedziny, której podstawy warto już dziś rozwijać na etapie szkolnym. W wielu przedmiotach szkolnych eksploracja danych odgrywa kluczową rolę, dlatego na lekcjach warto także podkreślać jej znaczenie i poszukiwać możliwości wykorzystania.

W części warsztatowej na ciekawych przykładach zaprezentuję narzędzia oparte na języku Python wraz z dedykowanymi bibliotekami do analizy danych, które można z łatwością wykorzystać w pracy dydaktycznej do efektywnej analizy i wizualizacji. Dzięki temu możliwe jest praktyczne wsparcie pracy z materiałem naukowym oraz rozwijanie umiejętności analitycznych.Speaker: Paulina Trybek (Uniwersytet Śląski w Katowicach) -

17:35

Let’s go quantum, czyli kwantowy komputer dla każdego 30m

Na przestrzeni ostatnich stu kilkudziesięciu lat byliśmy świadkami niesamowitego postępu naukowego i technologicznego. W tym okresie ludzkość poznała promieniotwórczość naturalną, pierwszy antybiotyk, motoryzację, Internet oraz rozpoczęła eksplorację kosmosu. Na początku XX wieku powstała mechanika kwantowa - teoria, która już od swego początku budziła wielkie emocje i kontrowersje, a dzięki której dziś jesteśmy w stanie zrozumieć zjawiska fizyczne w otaczającym nas świecie. Wiele wskazuje na to, że w niedalekiej przyszłości mechanika kwantowa stanie się nam jeszcze bliższa za sprawą komputerów i komunikacji kwantowej. W swoim krótkim wykładzie postaram się przybliżyć najważniejsze koncepcje i osiągnięcia w rozwoju mechaniki i technologii kwantowych, które mają szansę zrewolucjonizować podejście do przetwarzania informacji.

Speaker: Marcin Kurpas (Uniwersytet Śląski w Katowicach) -

18:10

Czy Excel może pomóc w rozwiązywaniu zadań z fizyki? 20mSpeaker: Paweł Perkowski (Wojskowa Akademia Techniczna)

-

18:35

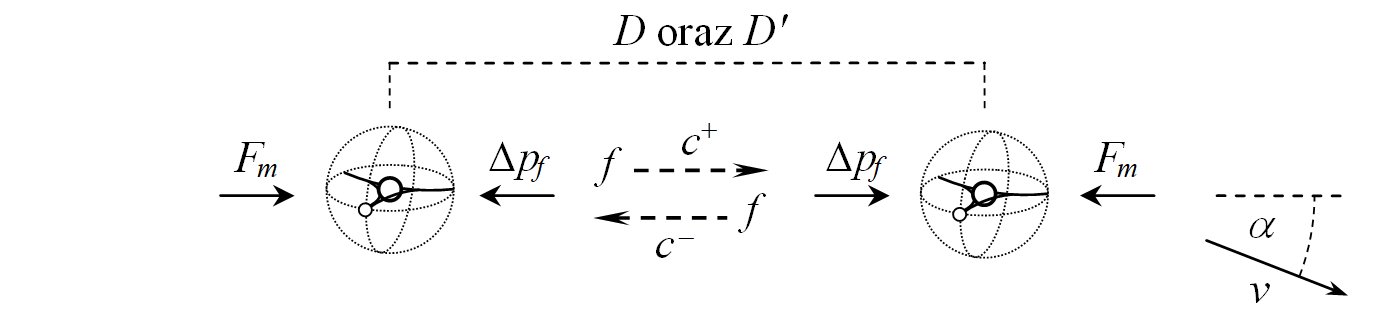

Układ doświadczalny do badania – w czasie rzeczywistym – sił w ruchu krzywoliniowym jako narzędzie dydaktyczne 20m

Celem wystąpienia jest zaprezentowanie układu doświadczalnego pozwalającego badać i prezentować siły działające na ciała poruszające się ruchem krzywoliniowym. Dynamiczne aspekty ruchu krzywoliniowego omawiane są najczęściej tylko teoretycznie. Nauczanie mechaniki, będącej podstawą wiedzy fizycznej, tradycyjnie rozpoczyna się od omówienia ruchu prostoliniowego, a wręcz tylko ruchu jednowymiarowego. Ma to miejsce nie tylko w nauczaniu powszechnym, ale także w szkolnictwie wyższym. U podłoża tej metody/tradycji wydaje się leżeć zasada stopniowania złożoności wprowadzanych do nauczania zagadnień. Ta zaś bierze się prawdopodobnie z powszechnego przekonania, że łatwiej jest przejść od szczegółu do ogółu, niż na odwrót. Jednak doświadczenia z pracy ze studentami (nawet wyższych lat studiów), lektury dostępnych opracowań zagadnień z mechaniki, wskazują na to, że związane z tym uproszenia często prowadzą do wyrobienia niewłaściwego wyobrażenia o ogóle/całości zagadnienia. Co gorsze, te niewłaściwe wyobrażenia fizyczne trudno jest zmienić. Zrozumienie przyczyn ruchu krzywoliniowego, czyli sił, jest rzeczywiście dużym wyzwaniem dla uczniów, studentów. Zastosowane przez nas nowoczesne czujniki siły i przyspieszenia oraz rejestracja danych w czasie rzeczywistym umożliwiają obserwowanie, jak wartość sił występujących w obserwowanym ruchu zmienia się w jego trakcie. Wizualizacja tych danych pozwala na dokładną analizę zależności między wielkościami opisującymi ruch i jego przyczynami. Sprzyja to lepszemu zrozumieniu podstawowych prawidłowości zjawisk fizycznych, związków przyczynowo-skutkowych w dowolnym ruchu (a więc także krzywoliniowym), ułatwia rozwijanie prawidłowej intuicji fizycznej. Układ zaprojektowałyśmy jako kompaktowy i łatwy w obsłudze, może więc on pełnić rolę wszechstronnej pomocy dydaktycznej zarówno w ramach systematycznego nauczania, jak i podczas pokazów fizycznych czy warsztatów. Wierzymy, że nasza propozycja nie tylko wzbogaci sposób przekazywania wiedzy z mechaniki klasycznej, ale także zainspiruje do szerszego wykorzystania nowoczesnych narzędzi eksperymentalnych w dydaktyce fizyki. Prezentowany układ pomiarowy jest według nas krokiem w stronę bardziej zrozumiałej, angażującej i skutecznej edukacji nauk ścisłych.

Speaker: Joanna Gondek (Uniwersytet Gdański)

-

17:00

-

17:00

→

19:00

Sesja dydaktyczna/naukowa III B.1.1

B.1.1

-

17:00

Metody dydaktyczne w uczeniu fizyki na poziomie akademickim - uwagi praktyka 30m

Przedstawione zostaną założenia teoretyczne oraz opis sposobu wdrożenia wybranych metod dydaktycznych na ćwiczeniach rachunkowych z podstaw mechaniki dla pierwszego semestru fizyki indywidualnej na Wydziale Fizyki Uniwersytetu Warszawskiego. Metody te obejmują:

- elementy Inquiry Based Learning,

- peer learning,

- gamifikacja zajęć,

- elementy turniejów fizycznych.

Przedstawione zostaną wnioski z własnych badań ewaluacyjnych oraz z ewaluacji zajęć przez studentów, co pozwoli na zderzenie perspektyw nauczyciela i ucznia (studenta). Dodatkowo uwzględnione zostaną doświadczenia z hospitacji takich zajęć przez specjalistów dydaktyków spoza dyscypliny nauki fizyczne.Speaker: Krzysztof Turzyński (Wydział Fizyki, Uniwersytet Warszawski) -

17:35

Szkoły letnie w dydaktyce akademickiej 30m

Szkoły letnie (ang. summer schools, academic summer camp) stają się co raz bardziej powszechnym elementem kształcenia akademickiego. Dowodem jest istotny wzrost liczby szkół letnich organizowanych przez europejskie i amerykańskie uniwersytety. Szkoły letnie i ich kalendarzowe odmiany mogą i powinny stać się skutecznym katalizatorem procesu umiędzynarodowienia szkolnictwa wyższego w Polsce.

Wieloletnie doświadczenia amerykańskie oraz doświadczenia niektórych uniwersytetów europejskich pokazują, że szkoły letnie mogą stanowić ważny element strategii oraz praktyki umiędzynarodowienia studiów oraz mogą ułatwić wdrażanie międzynarodowych standardów kształcenia. Organizacja szkół letnich wymusza silniejsze powiązanie programów kształcenia z otoczeniem społeczno-gospodarczym, szczególnie z innowacyjnym biznesem oraz stwarza możliwość wprowadzenia do kształcenia akademickiego specjalistów spoza uczelni. Metodologia tworzenia programów szkół letnich, nazywana często pedagogiką międzynarodowych kursów krótkoterminowych (ang. the pedagogy of international short-term courses) powinna uwzględnić dwie kluczowe kwestie: po pierwsze - najważniejsze założenia innowacyjnej pedagogiki uniwersyteckiej oraz kwestie dotyczące specyfiki kursów międzynarodowych.

Doświadczenia tych uniwersytetów, które podjęły się trudu organizacji szkół letnich pokazują, jak ważną rolę w zakresie umiędzynarodowienia procesu kształcenia one pełnią. Atrakcyjne kwalifikacje podnoszące rynkową wartość absolwentów, które można nabyć w ramach „intensywnych krótkich programów” stanowią znacznie silniejszy magnes dla studentów z zagranicy niż roczny lub semestralny pobyt w słabo rozpoznawalnych międzynarodowo polskich uczelniach.

Speaker: Ryszard Naskręcki (Uniwersytet im. Adama Mickiewicza w Poznaniu) -

18:10

Rola fokusu i empirii w dydaktyce mieszanej na styku szkoły i uczelni 20m

Nauczanie myślenia krytycznego i twórczego na lekcjach przedmiotów ścisłych jest znacznie utrudnione przez pokusy szybkiego dostępu do niezweryfikowanych informacji [1]. Współczesna dydaktyka fizyki staje przed wyzwaniem utrzymania uwagi uczniów w warunkach rosnącej dekoncentracji spowodowanej m.in. nadmiarem bodźców cyfrowych [2].

Fizyka jako nauka z definicji kognitywna nie może zatem polegać wyłącznie na formach podawczych i weryfikujących. Celem wystąpienia jest przedstawienie rozwiązań metodycznych, które z jednej strony wspierają używanie urządzeń mobilnych, a z drugiej angażują uczestniczącą młodzież.

Przedstawione zostaną przykłady prostych projektów do przeprowadzenia w domu lub klasie (por. Rys. 1), których realizacja kształtuje podstawowe kompetencje inżynierskie, uczy opracowania danych pomiarowych i stanowi urozmaicenie zajęć. Zastosowany tutoring sprzyja ponadto wzmacnianiu koncentracji, formowaniu postawy badawczej i przygotowuje uczniów do udziału w zajęciach akademickich na pracowni fizycznej Wydziału Fizyki i Informatyki Stosowanej AGH.References

[1] K. Radosz et al. “Aż 42,7% dzieci w wieku od 4 do 9 lat korzysta ze smartfona”. W: gov.pl – Krajowa Rada Radiofonii i Telewizji (2023), URL: https://www.gov.pl/web/krrit/az-427-dzieci-w-wieku-od-4-do-9-lat-korzysta-ze-smartfona.

[2] Instytut Pokolenia. “Smartfon – problemy i wyzwania. Raport 2025”. In: Instytut Pokolenia (Mar. 2025), URL: https://www.instytutpokolenia.org/wp-content/uploads/2025/03/RAPORT-Smartfon.pdf.Speaker: Mateusz Gala (AGH University) -

18:35

Fizyka w przestrzeni publicznej 20m

Planowane zmniejszenie liczby godzin dydaktycznych fizyki w szkole jest jednym z efektów małego poparcia społecznego dla tej dziedziny nauki. Pomysł nie spotkał się z istotną reakcją potencjalnych wyborów. Jakość edukacji nie jest była tematem ostatnich wyborów prezydenckich. Inżynieria i nauki ścisłe choć strategiczne nie są dostatecznie istotne dla społeczeństwa.

Wystąpienie będzie obejmowało analizę społecznego postrzegania fizyki oraz obecności osób posiadających wykształcenie ścisłe i techniczne w przestrzeni publicznej. Sformułowane zostaną proponowane rozwiązania, które pozwolą na większą obecność fizyki w przestrzeni publicznej.Speaker: Błażej Żyliński (Wydział Fizyki Politechniki Warszawskiej)

-

17:00

-

19:00

→

19:40

Dydaktyczna sesja plakatowa C.0.38

C.0.38

-

19:00

100 lecie badań ciekłych kryształów w Polsce 1924-2024 40mSpeaker: Paweł Perkowski (Wojskowa Akademia Techniczna)

-

19:00

Fizyka dla pokolenia Z i Alfa: od TikToka po teatr nauki – nowoczesne metody popularyzacji fizyki wśród dzieci i młodzieży 40m

Współczesne dzieci i młodzież dorastają w świecie zdominowanym przez szybkie, wizualne i interaktywne treści – od bajkowych historii po krótkie filmy na platformach takich jak TikTok czy YouTube. Tradycyjne formy nauczania i popularyzacji fizyki często nie odpowiadają na potrzeby pokolenia Z i Alfa, które oczekują treści atrakcyjnych, angażujących i dostosowanych do ich stylu uczenia się. W odpowiedzi na te wyzwania powstały dwie innowacyjne formy upowszechniania nauki: teatralne pokazy fizyki dla najmłodszych oraz projekt „TIKTOK-owa fizyka” skierowany do uczniów starszych klas szkół podstawowych i średnich.

Teatralna popularyzacja fizyki – poprzez przedstawienia inspirowane bajkami, takie jak „Jesienne czary mary”, „Fizyczna opowieść o Mikołaju i Rudolfie” czy „Wiosenne doświadczenia z jajem” – ukazuje zjawiska fizyczne w formie zabawy, angażując dzieci poprzez interaktywność, znane postacie i efektowną scenografię. Przedstawienia te nie tylko rozwijają kreatywność i ciekawość świata, ale również przystępnie tłumaczą zjawiska takie jak grawitacja, dyfuzja, tarcie czy działanie sił.

Z kolei projekt „TIKTOK-owa fizyka” odpowiada na potrzeby młodzieży preferującej krótkie, dynamiczne formy przekazu. Poprzez wykorzystanie popularnych mediów społecznościowych prezentowane są doświadczenia fizyczne – zarówno te wymagające specjalistycznego sprzętu, jak i możliwe do wykonania w domu. Dzięki tej formie fizyka przestaje być postrzegana jako trudna i niedostępna, stając się dziedziną bliską codziennemu życiu uczniów.Speaker: Magdalena Grajek (Uniwersytet im. A. Mickiewicza Wydział Fizyki i Astronomii) -

19:00

Metody wyznaczania stałej Plancka w studenckim laboratoriom fizycznym oraz w eksperymencie zdalnym 40mSpeaker: Stanisław Różański (Akademia Nauk Stosowanych w Pile)

-

19:00

Od lasera do biznesu – dydaktyka poprzez projekt w nauczaniu fizyki medycznej 40m

W warunkach dynamicznych przeobrażeń technologicznych i rosnącej konieczności rozwijania kompetencji praktycznych, implementacja metody Problem-Based Learning (PBL) stanowi istotny element modernizacji procesu kształcenia akademickiego. Przedmiot „Lasery w medycynie”, realizowany na kierunku fizyka medyczna, został przekształcony z tradycyjnego kursu wykładowo‑ćwiczeniowego w przestrzeń aktywnego uczenia się, osadzoną w paradygmacie konstruktywistycznym i nastawioną na rozwój autonomii uczących się.

Cele dydaktyczne zostały sformułowane nie tylko w kategoriach opanowania wiedzy teoretycznej dotyczącej zastosowań laserów w medycynie, lecz przede wszystkim w odniesieniu do kształtowania umiejętności analizy problemów, współpracy zespołowej oraz myślenia projektowego. Kluczowym zadaniem powierzonym studentom było opracowanie koncepcji firmy wykorzystującej technologię laserową w praktyce medycznej – od identyfikacji potrzeby rynkowej, poprzez dobór odpowiedniego typu lasera i oceny jego zastosowania w wybranych działach medycyny. Konstrukcja problemu dydaktycznego sprzyjała rozwijaniu kreatywności, zdolności do integracji wiedzy z różnych obszarów i pogłębionemu rozumieniu zagadnień fizycznych i ich praktycznego zastosowania.

Na plakacie przedstawiono strukturę kursu, projekt studencki oraz wnioski z ewaluacji dydaktycznej. Wyniki wskazują, że metoda PBL wspiera rozwój kompetencji kluczowych przyszłych specjalistów fizyki medycznej, łącząc transfer wiedzy akademickiej z wymaganiami rynku pracy oraz kształcąc postawy przedsiębiorcze i innowacyjne.

Speaker: Małgorzata Paprzycka (Wydział Fizyki i Astronomii UAM) -

19:00

Odbiór społeczny fizyki. Rola mediów i nowoczesnych technologii informacyjnych. 40m

Odbiór społeczny fizyki to zagadnienie różnorodne zależące od wielu czynników, takich jak wiedza i zainteresowania osób, ich grupa wiekowa i edukacja, a także kontekst społeczny. W ogólnym aspekcie, fizyka jest postrzegana jako trudna, abstrakcyjna, ale również fascynująca i ważna dziedzina wiedzy.

Główne aspekty odbioru społecznego fizyki polegają na:

• postrzeganiu fizyki jako trudnej dziedziny nauki:

Wiele osób uważa fizykę za trudną do zrozumienia, co związane jest z jej abstrakcyjnymi pojęciami i matematycznym językiem.

• fascynacji i zainteresowaniu:

Mimo trudności, fizyka przyciąga uwagę wielu osób ze względu na jej zdolność do wyjaśniania świata i zjawisk w nim zachodzących.

• ważności dla postępu technicznego:

Fizyka jest uważana za fundamentalną naukę, która ma duży wpływ na rozwój technologii i innowacji.

• inspiracji dla przyszłych pokoleń:

Fizyka może być inspiracją dla młodych ludzi, którzy chcieliby wybrać karierę naukową lub techniczną.

• rozwoju wiedzy i świadomości:

Fizyka przyczynia się do rozwoju wiedzy i świadomości społeczeństwa na temat świata, w którym żyjemy.

• roli mediów:

Fizyka często pojawia się w mediach, co wpływa na sposób, w jaki społeczeństwo postrzega tę dziedzinę nauki. Reforma systemu edukacji sukcesywne wdrażana od 2000 roku w przypadku nauczania fizyki postulowała uzupełnienie edukacji szkolnej edukacją pozaszkolną polegająca na korzystaniu z muzeów nauki, festiwalów nauki i pikników naukowych oraz przez umożliwienie wspomagania nauki szklonej przez różne inicjatywy edukacyjne i popularyzatorskie organizowane przez instytucje naukowe, wydziały fizyki na uczelniach wyższych, instytuty naukowe czy wyspecjalizowane organizacje pozarządowe. Twórcy reformy systemu edukacji uważali, że edukacja człowieka nie może zakończyć się tylko na nauczaniu szkolnym, gdyż wobec szybkiego rozwoju wiedzy naukowej, dorośli powinni dalej poszerzać swoją wiedzę samodzielnie. Edukacji dorosłych miały służyć, tak jak młodzieży szkolnej, muzea nauki, festiwale nauki i pikniki naukowe, ale także media. Twórcy reformy edukacji określili rolę mediów w dokształcaniu uczniów i dorosłych jako edukacyjną i popularyzatorską.

Czy jednak media spełniają rolę założoną przez twórców reformy edukacji?

Media obecnie są inne niż wtedy, gdy władze edukacyjne opracowywały założenia reformy. Oprócz tradycyjnych mediów działają także media wykorzystujące nowe technologie informatyczne. Jakkolwiek nowe technologie umożliwiają szybki przekaz wiedzy użytkownikom w formiY blogów, podcastów, kanałów tematycznych na platformie filmowej youtube, to jednak większość społeczeństwa nadal korzysta z tradycyjnych form przekazu medialnego poprzez telewizję, radio i prasę, a te środki przekazu obecnie nie działają tak samo jak kiedyś. Media tradycyjne niestety poddały się komercjalizacji i dlatego informacje naukowe są przez nie podawane tak jak sensacje, newsy, a naukowcy są traktowani jak celebryci. Co więcej, oprócz rzetelnej wiedzy, media lansują pseudonaukę korzystając z braku kontroli ze strony środowiska naukowego, a także braku środków na zatrudnianie konsultantów naukowych. Szkodliwym społecznie zjawiskiem jest usilne upowszechnianie teorii naukowych oraz nowych odkryć naukowych i technicznych w codziennym życiu w wypaczonej interpretacji, co prowadzi do kompletnego chaosu pojęciowego. Ciągle pokutuje wypaczona przez media interpretacja fizyki kwantowej, spowodowana niedawnymi osiągnięciami w tej dziedzinie w zakresie budowy komputerów kwantowych i kryptologii, a już doszła nowa dziedzina wiedzy do interpretacji medialnej, tzn. sztuczna inteligencja.

Przedstawione powyżej aspekty zagadnienia odbioru społecznego fizyki zostaną rozwinięte i uzupełnione o ciekawe dla nauczycieli i dydaktyków fizyki przykłady w opracowywanym plakacie.Speaker: Edward Rydygier (Międzynarodowy Instytut McLeoda Nauk Symulacyjnych, Oddział w Polsce) -

19:00

Popularyzacja fizyki a nowoczesna dydaktyka – jak łączyć atrakcyjność z rzetelnością naukową? 40m

Celem wystąpienia jest przedstawienie sposobów popularyzacji fizyki wśród młodzieży szkół średnich oraz pokazanie, jak nowoczesna dydaktyka może łączyć atrakcyjne treści z wymaganiami podstawy programowej.

The aim of the presentation is to show how to popularize physics among high school students and how modern teaching methods can combine engaging content with curriculum requirements.

Przedstawienie nowoczesnych strategii popularyzowania fizyki w ramach formalnej edukacji pokazuje, że atrakcyjność przekazu można skutecznie łączyć z rzetelnością naukową. Prezentacja skupia się na metodach dydaktycznych, które pomagają uczniom zrozumieć i zainteresować się fizyką jako nauką praktyczną i interdyscyplinarną.

W dobie cyfrowej nadprodukcji informacji fizyka często przegrywa z mitami i uproszczeniami, tymczasem można ją skutecznie promować, sięgając po narzędzia kultury popularnej, aktualne wydarzenia naukowe i projekty edukacyjne.

Jako przykłady, podaję sprawdzone działania:

Analiza filmu Marsjanin jako wprowadzenie do tematów produkcji wody, fotosyntezy, ciśnienia atmosferycznego; Dyskusja o filmie „Grawitacja”, tematy: „Czy postać Clooney’a musiała się odłączyć? Zasada zachowania pędu; Brak sił zewnętrznych w przestrzeni”;

Wykonanie ćwiczeń: Fizyka czy fikcja? Oglądanie scen, Czy dana sytuacja jest możliwa fizycznie? Argumentacja z wykorzystaniem praw fizyki.

Wykonanie projektu: Poradnik dla astronauty: Jak pić wodę w kosmosie? Toaleta i higiena bez grawitacji; Znaczenie ćwiczeń na ISS.

Wykorzystanie wydarzeń popularnonaukowych (np. wizyta Kipa Thorne’a na Uniwersytecie Lwowskim) jako punktów wyjścia do debat;

Realizacja kart pracy, plansz dyskusyjnych, quizów i projektów zgodnych z podejściem STEAM.

Celem tych i innych działań jest podkreślenie, że skuteczne nauczanie fizyki wymaga zaangażowania, kreatywności oraz tworzenia powiązań między nauką a codziennym życiem ucznia.

Popkultura to skuteczne narzędzie w nauczaniu fizyki, a filmy i życie astronautów wspierają zrozumienie teorii. Korzyści z wykorzystania popkultury to:

Większe zaangażowanie uczniów, zrozumienie przez przykład, rozwijanie krytycznego myślenia.Speaker: Tetiana Grott -

19:00

PROGRAM MATHEMATICA W NAUCZANIU FIZYKI 40m

Od ponad 20 lat na Politechnice Śląskiej są prowadzone zajęcia „laboratorium komputerowe z fizyki”. Są to ćwiczenia rachunkowe z fizyki „wspomagane” programem MATHEMATICA.

Program ma bardzo rozbudowaną pomoc zawierającą opis wszystkich komend z przykładami, co ułatwia studentom opanowanie składni i zrozumienie jego struktury logicznej. Wykorzystanie obliczeniowych technik komputerowych do rozwiązywania zadań i problemów z fizyki pozwala na głębszą analizę fizyczną omawianych zjawisk. Prowadzący zajęcia ma do dyspozycji zaoszczędzony czas potrzebny studentom

na zajęciach „klasycznych” (bez wykorzystaniu programu) do wykonywania obliczeń matematycznych. Dodatkowym atutem jest możliwość rozwiązywania danego zadania (pisania

algorytmu w programie MATHEMATICA) przez wszystkich studentów jednocześnie, a nie tylko przez jedną osobę na tablicy. Stopień trudności rozwiązania zadań jest bardzo szeroki. Najprostsze wymagają tylko wstawienia wartości do

wzorów bez konieczności rozwiązywania równań, w przypadku najtrudniejszych należy rozwiązać numerycznie równania różniczkowe cząstkowe.Speaker: Piotr Duka (politechnika śląska, zakład fizyki ciała stałego) -

19:00

Realizacja metody Project-Based Learning w Instytucie Fizyki - Centrum Naukowo-Dydaktycznym Politechniki Śląskiej – efekty, doświadczenia i zaangażowanie studentów w działalność naukową 40m

W Instytucie Fizki - Centrum Naukowo-Dydaktycznym Politechniki Śląskiej z powodzeniem wdrażana jest metodyka Project-Based Learning (PBL), oparta na uczeniu się poprzez realizację projektów. Model ten pozwala studentom na bezpośrednie zastosowanie wiedzy teoretycznej w praktyce oraz rozwija kluczowe kompetencje przyszłych inżynierów i naukowców, takie jak kreatywność, umiejętność rozwiązywania problemów, współpraca zespołowa czy krytyczne myślenie.

Realizowane w ramach PBL projekty często mają charakter interdyscyplinarny, co znacznie poszerza posiadaną przez studentów wiedzę. Studenci nie tylko pogłębiają zrozumienie zjawisk fizycznych, ale również aktywnie włączają się w działalność naukową – uczestniczą w przygotowaniu wystąpień konferencyjnych, są współautorami artykułów naukowych, a także zgłoszeń patentowych. Taka forma kształcenia stanowi realne wprowadzenie studentów w świat badań naukowych już na etapie studiów.

W prezentacji omówione zostaną przykłady projektów, osiągnięte rezultaty dydaktyczne oraz konkretne efekty naukowe wynikające z zaangażowania studentów. Zebrane doświadczenia potwierdzają skuteczność podejścia PBL w kształtowaniu zarówno kompetencji technicznych, jak i naukowych, a także w budowaniu mostu między dydaktyką a działalnością badawczą.Speaker: Sławomira Pawełczyk (Politechnika Śląska) -

19:00

Rola i zastosowanie metody PBL jako odpowiedź na potrzeby współczesnego pokolenia 40m

W dobie zmian pokoleniowych oraz rosnących oczekiwań względem skuteczności i personalizacji edukacji, tradycyjne metody nauczania fizyki okazują się niewystarczające. Współczesne pokolenie studentów potrzebuje angażujących, praktycznych i problematyzujących form nauki, które lepiej odzwierciedlają realne wyzwania zawodowe. W prezentacji przedstawiona zastanie metoda Problem-Based Learning (PBL) w dydaktyce fizyki medycznej, ze szczególnym uwzględnieniem kontekstu klinicznego związanego z diagnostyką obrazową i dawkami promieniowania jonizującego. Studenci, pracując w grupach, mieli za zadanie zaplanowanie procesu diagnostyczno-terapeutycznego dla pacjenta z wieloma jednostkami chorobowymi, uwzględniając limity dawek rocznych, różnice norm w zależności od regionu świata, a także koszty leczenia i profilaktyki. Zadanie obejmowało również wykorzystanie elementów symulacji medycznej, takich jak patologiczny chód czy wady wzroku, pozwalających lepiej zrozumieć sytuację pacjenta. Zostaną omówione korzyści płynące z zastosowania metody PBL w kształceniu przyszłych fizyków medycznych oraz jej wpływ na rozwój kompetencji praktycznych, analitycznych i empatycznych, niezbędnych w pracy zawodowej w systemie ochrony zdrowia ukierunkowanym na jakość, bezpieczeństwo i optymalizację kosztów. Dodatkowo przedstawione zostaną konkretne przykłady zastosowania PBL w nauczaniu fizyki, podkreślając ich skuteczność w budowaniu głębokiego zrozumienia zagadnień fizycznych poprzez realne konteksty i interdyscyplinarne podejście. Poruszona zostanie także kwestia odbioru przez studentów, zajęć prowadzonych z wykorzystaniem metody PBL.

Speaker: Magdalena Grajek (Uniwersytet im. A. Mickiewicza Wydział Fizyki i Astronomii) -

19:00

Wirtualna Akademia Astronomii jako wspólna droga szkół i uniwersytetów 40m

Wirtualna Akademia Astronomii to Instytucja działająca na Uniwersytecie Opolskim, we współpracy z Opolskim Towarzystwem Przyjaciół Nauk, wspierająca popularyzację astronomii

i fizyki wśród szkół i młodzieży. Nauczyciele chętni do współpracy z WAA tworzą kółka astronomiczno-fizyczne, mogą też zaprosić naukowca z Uniwersytetu Opolskiego do wygłoszenia prelekcji lub przeprowadzenia obserwacji. WAA zaprasza również grupy młodzieży

na Uniwersytet Opolski, na spotkania publiczne lub specjalnie przygotowane dla grupy.

WAA organizuje trzy konkursy „Odkrywca światów” w każdym roku akademickim: plastyczny, literacki i fotograficzny. W ramach Wirtualnej Akademii Astronomii organizowane są również Seminaria Astronomiczne i wyjazdy naukowe w formie warsztatów czy obozów.

Plakat przedstawia 11 lat działalności Wirtualnej Akademii Astronomii, możliwości współpracy i rozwoju.Speaker: Katarzyna Książek (Instytut Fizyki Uniwersytetu Opolskiego, Publiczna Katolicka Szkoła Podstawowa w Opolu, Publiczne Liceum Ogólnokształcące nr 2 w Opolu) -

19:00

Współczesne trendy w nauczaniu biofizyki i fizyki medycznej - interdyscyplinarność i kształcenie symulacyjne 40m

Studenci różnych kierunków medycznych, zarówno na uniwersytetach jak i w uczelniach zawodowych, jakimi w Polsce są akademie nauk stosowanych, w trakcie edukacji obowiązkowo realizują przedmioty związane z szeroko pojętą fizyką. Znajomość fundamentalnych praw przyrody i właściwości materii jest bowiem niezbędna do ilościowego wyjaśnienia zasad funkcjonowania ludzkiego organizmu oraz zrozumienia zasad działania nowoczesnego sprzętu, stanowiącego podstawę współczesnej diagnostyki i terapii.

Edukacja w tym zakresie powinna zaczynać się już w szkole średniej. Niestety, uczniowie klas biologiczno-chemicznych często nie dostrzegają potrzeby zgłębiania tajników fizyki. Zwraca uwagę brak interdyscyplinarności nauczania oraz ciągłe powielanie w podręcznikach typowych przykładów wykorzystania fizyki w życiu codziennym bez powiązań z medycyną i naukami o życiu. Nie bez znaczenia pozostaje też niewystarczająca wiedza niektórych nauczycieli w zakresie zastosowania metod fizycznych w medycynie. W odpowiedzi na ten problem autor przygotował dotychczas cykl 35 artykułów popularyzatorsko-dydaktycznych, które ukazują się od 2014 na łamach czasopisma dla nauczycieli „Fizyka w Szkole z Astronomią”. Podejmowane w nich, zazwyczaj niestandardowe tematy, takie jak: fizyka u pulmonologa [1], kardiologa [2], okulisty i optometrysty [3], internisty [4] czy fizjoterapeuty [5] mają za zadanie pokazać rolę fizyki w pracy różnych specjalistów z branży medycznej.

Kształcenie samych studentów, głównie w ramach zajęć z biofizyki i przedmiotów związanych z fizyką medyczną, powinno czerpać inspirację z najnowszych trendów obowiązujących chociażby w uczelniach przygotowujących do zawodu pielęgniarki. Mowa tu oczywiście o kształceniu symulacyjnym. Pozwala ono znakomicie pogłębiać wiedzę, a przede wszystkim rozwijać samodzielność myślenia, umiejętności praktyczne oraz kompetencje społeczne. Interaktywne zajęcia, przeprowadzane w małych grupach w kontrolowanym środowisku, muszą oczywiście mieć charakter eksperymentalny oraz być realizowane według opracowanego przez prowadzącego scenariusza. Standardowo ćwiczenia składają się z trzech części. Pierwsza z nich ma charakter wprowadzenia, w ramach którego uczestnicy otrzymują instrukcje oraz niezbędne informacje. Drugim etapem jest właściwa sesja symulacyjna. Jako przykład można przedstawić zadanie polegające na rejestracji elektrycznej aktywności serca i interpretacji otrzymanych wyników. W przypadku tzw. symulacji wysokiej wierności oprócz rejestratora sygnałów elektrokardiograficznych stosuje się specjalistyczne fantomy, doskonale naśladujące wygląd człowieka oraz jego reakcje. Taki zaawansowany zestaw doświadczalny umożliwia prowadzącemu zaprogramowanie i wygenerowanie rytmów, jakie towarzyszą najrozmaitszym patologiom, związanym np. z zaburzeniem przewodzenia elektrycznego w obrębie mięśnia sercowego. Ważne, że symulować można nie tylko różne stany fizjologiczne, ale również zdarzenia nietypowe, takie jak niespodziewana awaria sprzętu. Na tym etapie studenci muszą wykazać się zatem otwartym umysłem, refleksem, kreatywnością, samodzielnością, umiejętnością pracy w zespole a przede wszystkim przekładaniem wiedzy teoretycznej na działanie praktyczne. Co najważniejsze, symulacje zapewniają powtarzalność i sprawiają, że można bezpiecznie prowadzić ćwiczenia bez konieczności zaangażowania żywych osób w charakterze pacjentów. Trzecia część zajęć stanowi natomiast podsumowanie prawidłowości realizacji scenariusza przez studentów. Towarzyszy temu nieodłączna dyskusja, a dogłębna analiza popełnionych błędów sprawia, że studenci mogą wyciągnąć konstruktywne wnioski na przyszłość.

Praktyczne kształcenie symulacyjne niewątpliwie ma szansę zrewolucjonizować nauczanie biofizyki, jedyną jego wadą jest wysoka cena zaawansowanych technicznie symulatorów.

Literatura:

[1] T. Kubiak, Fizyka u pulmonologa, Fizyka w Szkole z Astronomią, nr 3 (2024), s. 4-13.

[2] T. Kubiak, Fizyka u kardiologa, Fizyka w Szkole z Astronomią, nr 3 (2023), s. 4-11.

[3] T. Kubiak, Fizyka u okulisty i optometrysty, Fizyka w Szkole z Astronomią, nr 5 (2023), s. 4-13.

[4] T. Kubiak, Fizyka u internisty, Fizyka w Szkole z Astronomią, nr 2 (2018), s. 4-7.

[5] T. Kubiak, Od światłolecznictwa do elektroterapii, czyli podstawy wybranych metod fizykoterapii, Fizyka w Szkole z Astronomią, nr 1 (2022), s. 4-11.Speaker: Tomasz Kubiak (Wydział Fizyki i Astronomii, Uniwersytet im. Adama Mickiewicza w Poznaniu)

-

19:00

- 19:00 → 19:40

- 19:00 → 20:30

-

08:00

→

08:30

-

-

09:00

→

11:00

Astrofizyka B.0.38

B.0.38

-

09:00

Soczewkowanie grawitacyjne w badaniu fundamentalnych własności natury / Gravitational lensing as a tool for studying fundamental properties of nature 20mSpeaker: Aleksandra Piórkowska-Kurpas (Uniwersytet Śląski w Katowicach / University of Silesia in Katowice)

-

09:20

Search for dark matter with the DarkSide-20k detector 20m

The nature of dark matter remains unknown, and its origin is currently one of the most important questions in physics. One of the most promising technologies to directly observe interactions of Weakly Interactive Massive Particles (WIMPs), a dark matter candidate, with ordinary matter is based on the use of a large mass of liquid argon as a target.

A general overview and status of the DarkSide-20k detector, now under construction in the Gran Sasso National Laboratory (LNGS) in Italy, will be presented in a broader context of the Global Argon Dark Matter Collaboration physics programme. DarkSide-20k aims to directly detect dark matter by observing weakly interacting massive particles (WIMPs) scattering off the nuclei in 20 tonnes of low radioactivity liquid argon in the dual-phase time projection chamber (TPC).

Special emphasis will be given to the Polish contributions to the project:

-

Cryogenic testing of the veto silicon photomultiplier modules

-

The light collection scheme for the veto detector, consisting of approx. 200 square meters of a novel polymeric wavelength shifting reflector film, based on polyethylene naphthalate

-

Precise screening for traces of natural radioactivity in construction materials as a method to minimize the DarkSide-20k detector background.

Speaker: Marcin Kuźniak (AstroCeNT / CAMK PAN) -

-

09:40

The new nanorocket propulsion mechanism based on fast water expulsion from hydrophobic porous materials 20mSpeaker: Yuriy Bushuev (University of Silesia in Katowice)

-

10:00

LEGEND - a next generation experiment for searches of neutrino-less double beta decay 20m

The LEGEND experiment has been designed to search for neutrinoless double-beta decay (0vbb) in Ge-76. Its discovery would have profound implications for neutrino physics and cosmology providing unambiguous evidence for the Majorana nature of neutrinos, lepton number non-conservation and the absolute neutrino mass scale. The LEGEND-1000 detector represents the ton-scale phase of the LEGEND program, following the current intermediate stage called LEGEND-200 and currently carried out at LNGS in Italy. The LEGEND-200 (L-200) first results are based on 61 kgxyr of exposure. Data from GERDA and the Majorana Demonstrator were combined with L-200 for a joint analysis, yielding a 90% CL sensitivity of 2.8x10^26 yr and setting a new lower limit of >1.9x10^26 yr, for the half-life of 0vbb. Assuming the decay mechanism is mediated by the exchange of a light Majorana neutrino, this half-life limit corresponds to an upper limit on the effective Majorana mass of mbb <75-200 meV.

The LEGEND-1000 will be based on p-type, inverted-coaxial, point-contact germanium detectors enriched in Ge-76 up to about 90 %. The detectors will be operated in an active shield based on underground argon (argon extracted from an underground source, depleted in Ar-39 and Ar-42). This approach proved to guarantee the lowest background levels and the best energy resolution at the decay Q value. The anticipated quasi background-free operation will allow for 0vbb decay in Ge-76 at a half-life beyond 10^28 yr and a discovery sensitivity spanning the inverted-ordering neutrino mass scale.

The LEGEND-1000 Collaboration is successfully seeking funding from US and European agencies. The construction of the detector in Hall C of the underground laboratory of LNGS in Italy should start in 2026 and will take about 8 years. Start of data taking is foreseen for 2029.

Speaker: Grzegorz Zuzel (Jagiellonian University) -

10:20

The analysis of a rare deep extensive air shower using Top-Down reconstruction chain 20m

The Top-Down reconstruction chain is a Monte Carlo simulation framework designed to reconstruct extensive air showers while addressing the observed muon discrepancy—the excess of muons in data compared to simulations. We apply this method to a rare event detected by the Pierre Auger Observatory, notable for its exceptionally large depth of shower maximum. This rare event may even suggest exotic physics. To analyze its probability of being a hadron or photon, we try to reconstruct it using the Top-Down chain. The analysis has shown the need for modifications of the procedure: increasing the number of simulations, introducing additional quality cuts, and others. We present the reconstructed event that best matches the observations and analyze the top matches to quantify the muon discrepancy. Finally, we assess the likelihood of the primary particle being a hadron or photon.

Speaker: Megha Mogarkar (Institute of Nuclear Physics (IFJ PAN)) -

10:40

Status and recent results from the DEAP-3600 Experiment 20m

The true nature of dark matter remains a mystery, and uncovering its origin in the Universe is one of the foremost challenges in physics. Direct detection efforts focus on searching for interactions between weakly interacting massive particles (WIMP), one of favored dark matter candidates, and ordinary matter. Experiments are located in deep underground laboratories, where cosmic ray backgrounds are minimized. Among the most promising detection methods is the use of a substantial volume of liquid argon as a target material.

In this talk, I will present the design and operational status of the liquid argon single-phase DEAP-3600 Experiment, which has been taking data 2 km underground at SNOLAB, (Sudbury, Canada) since 2016. Further on, I will talk about recent results, including an overview of the WIMP search, the direct measurement of the Ar-39 half-life and the first observation of neutrino absorption on argon.Speaker: Michal Olszewski (CAMK)

-

09:00

-

09:00

→

11:00

Infrastruktura badawcza B.1.1

B.1.1

-

09:00

Europejska infrastruktura badawcza Extreme Light Infrastructure - ELI ERIC 30m

Europejska infrastruktura badawcza Extreme Light Infrastructure – ELI ERIC składa się z trzech ośrodków badawczych: ELI ALPS (Attosecond Light Pulse Source), zlokalizowanego w Szeged na Węgrzech, ELI Beamlines, znajdującego się w miejscowości Dolni Brezany w Czechach oraz ELI NP (Nuclear Physics), zbudowanego w miejscowości Magurele w Rumunii. W ośrodkach tych znajdują się unikalne na świecie systemy impulsowych laserów wielkiej mocy, przeznaczone do prowadzenia badań naukowych w różnych dziedzinach nauki i techniki. Badania te dotyczą oddziaływania z materią impulsów laserowych o ekstremalnych parametrach, czasie trwania oraz intensywności impulsów promieniowania, jak również zastosowania wtórnego promieniowania elektromagnetycznego i cząstek naładowanych o wysokiej energii, wytwarzanych tymi impulsami.

Programy badawcze poszczególnych ośrodków ELI obejmują bardzo szeroki zakres dziedzin i dyscyplin naukowych. W ośrodku ELI-ALPS prowadzone są prace dotyczące wytwarzania laserami ultrakrótkich impulsów promieniowania o czasie trwania w zakresie attosekundowym i ich zastosowania w badaniach dynamiki ultraszybkich procesów zachodzących w atomach, molekułach, plazmie i ciałach stałych. Planowane są w nim także badania w zakresie biologii i medycyny z zastosowaniem wiązek wysokoenergetycznych protonów przyspieszanych laserami. Program badawczy ośrodka ELI-Beamlines dotyczy wytwarzania laserem impulsów promieniowania elektromagnetycznego w szerokim zakresie widmowym, od nadfioletu próżniowego do twardego promieniowania rentgenowskiego oraz strumieni wysokoenergetycznych cząstek naładowanych i ich zastosowania w badaniach w obszarze fizyki ciała stałego, optyki atomowej i molekularnej, chemii, biologii i inżynierii biomedycznej i medycyny. Ponadto planowane są badania oddziaływania impulsów laserowych z materią przy ultra wysokich intensywnościach promieniowania powyżej 1023 Wcm-2, umożliwiające prowadzenie eksperymentów w obszarze elektrodynamiki kwantowej. Badania prowadzone w ośrodku ELI-NP dotyczą głównie zastosowania impulsowych laserów wielkiej mocy w fizyce jądrowej. Obecnie w tym ośrodku znajduje się system laserowy wytwarzający impulsy promieniowania o największej na świecie intensywności, a w przyszłości najważniejszym urządzeniem badawczym będzie unikalne źródło impulsów promieniowania γ oparte na rozpraszaniu Comptona wiązki laserowej na wysokoenergetycznych elektronach.

W referacie zaprezentowana będzie organizacja infrastruktury ELI ERIC oraz warunki z jej korzystania przez użytkowników zewnętrznych. Następnie, podana zostanie krótka charakterystyka systemów laserowych oraz aparatury badawczej dostępnej w ośrodkach ELI. Przedstawiona będzie także działalność krajowego konsorcjum ELI – Polska, skupiającego uczelnie i instytuty naukowe zainteresowane infrastrukturą ELI ERIC, mająca na celu jej popularyzację w środowisku naukowym w Polsce oraz zwiększenie udziału polskich naukowców wśród użytkowników tej unikalnej na świecie infrastruktury badawczej.Speaker: Henryk Fiedorowicz (Instytut Optoelektroniki, Wojskowa Akademia Techniczna, Warszawa) -

09:30

Perspektywy badań fizyki jądrowej z wykorzystaniem wielkich europejskich infrastruktur badawczych- FAIR i SPIRAL2 30m

Facility for Antiproton and Ion Research (FAIR) w Darmstadt w Niemczech oraz Système de Production d’Ions Radioactifs en Ligne de 2e Génération (SPIRAL2) w GANIL w Caen we Francji należą do europejskich strategicznych infrastruktur badawczych i są największymi ośrodkami akceleratorowymi budowanymi obecnie na naszym kontynencie z udziałem polskich naukowców i inżynierów. Obydwie instalacje będą dysponować niespotykanymi nigdzie indziej wiązkami ciężkich jonów, które umożliwią interdyscyplinarne, innowacyjne badania: od struktury egzotycznych jąder atomowych, astrofizyki jądrowej i własności ekstremalnych stanów materii jądrowej po fizykę atomową, naświetlanie materiałów i zastosowania w radiobiologii i medycynie.

Motywem przewodnim wykładu będzie przedstawienie zaangażowania polskich fizyków jądrowych w wyposażenie stanowisk eksperymentalnych FAIR i SPIRAL2 jak i w planowane z ich użyciem programy badawcze. W szczególności, omówione zostaną możliwości wykorzystania wtórnych wiązek radioaktywnych jonów do wytwarzania krótkożyciowych nuklidów, oddalonych od ścieżki stabilności beta i badania nietypowych własności tych egzotycznych jąder.Speaker: Piotr Bednarczyk (IFJ PAN) -

10:00

Wielkie eksperymenty w CERN i udział w nich polskich grup badawczych 30m

CERN, czyli Europejska Organizacja Badań Jądrowych (z fr. Conseil Européen pour la Recherche Nucléaire), to największe na świecie laboratorium fizyki cząstek, położone na pograniczu Szwajcarii i Francji. Polska, będąca członkiem CERN od 1991 roku, aktywnie uczestniczy w badaniach prowadzonych w tym unikalnym ośrodku. Obecnie CERN kojarzony jest przede wszystkim z budową i działaniem Wielkiego Zderzacza Hadronów (LHC – Large Hadron Collider) – największego i najpotężniejszego akceleratora cząstek na świecie. Wokół LHC powstały cztery główne eksperymenty, w których uczestniczą tysiące naukowców z całego globu, w tym liczne zespoły badawcze z Polski.

Podczas wystąpienia zostaną przedstawione przykłady najważniejszych eksperymentów prowadzonych w CERN, takie jak ATLAS, CMS, ALICE czy LHCb, oraz wkład polskich grup badawczych w ich rozwój i funkcjonowanie. Omówione zostaną zarówno aspekty teoretyczne, jak i technologiczne polskich prac – od udziału w budowie detektorów, przez analizy danych, aż po rozwój infrastruktury informatycznej. Wystąpienie pokaże, jak polscy naukowcy współtworzą światową naukę, a także jak ich praca przyczynia się do poszerzania naszej wiedzy o fundamentalnej strukturze materii i Wszechświata.

Speaker: Dominik Derendarz (Instytut Fizyki Jądrowej PAN) -

10:30

Polskie infrastruktury fizyki jądrowej (SLCJ, CCB, VA Theo4Exp) 30m

Rozwój fizyki jądrowej w Polsce opiera się na komplementarnych ośrodkach badawczych, umożliwiających prowadzenie badań eksperymentalnych i teoretycznych na światowym poziomie. W wystąpieniu przedstawione zostaną trzy kluczowe ośrodki i inicjatywy: Środowiskowe Laboratorium Ciężkich Jonów (SLCJ) w Warszawie, Centrum Cyklotronowe Bronowice (CCB przy IFJ PAN) w Krakowie oraz Wirtualna Platforma obliczeniowa Theo4Exp – mająca na celu udostępnianie wyników narzędzi i obliczeń teoretycznych dla eksperymentalnej fizyki jądrowej.

Omówione zostaną możliwości badawcze akceleratorów i detektorów dostępnych w SLCJ i CCB, aktualne programy badawcze, a także perspektywy ich rozwoju w kontekście współpracy krajowej i międzynarodowej. Szczególna uwaga poświęcona zostanie roli VA Theo4Exp jako forum wspierającego integrację wiedzy, edukację młodych naukowców oraz jako narzędzie wspierające planowanie projektów badawczych. Prezentacja będzie również okazją do dyskusji nad przyszłością polskich infrastruktur jądrowych w świetle europejskich inicjatyw i map drogowych.

Speaker: Michał Ciemała (IFJ PAN)

-

09:00

-

09:00

→

11:00

InnoFusion: Sesja wystąpień ustnych C.0.37

C.0.37

-

09:00

→

11:00

Sesja dydaktyczna/naukowa IV B.0.39

B.0.39

-

09:00

Fale grawitacyjne - 10 lat przełomowych obserwacji 35m

10 lat temu, 14 września 2015 po raz pierwszy w historii nauki zarejestrowano fale grawitacyjne (zaburzenia czasoprzestrzeni) wytworzone podczas połączenia się dwóch gwiazdowych czarnych dziur w jedną, rotującą czarną dziurę. Praca miedzynarodowego zespołu detektorów LIGO (USA) i Virgo (Włochy) została w 2017 roku uhonorowana nagrodą Nobla z fizyki. Detekcji, sygnału GW150914 dokonały dwa detektory interferometryczne LIGO w USA. Przełomowa detekcja była potwierdzeniem przewidywań ogólnej teorii względności Alberta Einsteina (1915), bezpośrednią obserwację czarnych dziur i otworzyła zupełnie nowe okno obserwacyjne na Wszechświat. Od tamtej pory zaobserwowaliśmy ponad 300 źródeł fal grawitacyjnych, głównie układów podwójnych czarnych dziur. Obserwacje fal grawitacyjnych pozwoliły nam dokonać wielu przełomowych odkryć. Ogólna teoria względności została potwierdzona w reżimie silnego pola, co jeszcze niedawno było nieosiągalne. Wykrycie połączenia się dwóch gwiazd neutronowych GW170817, któremu towarzyszył rozbłysk gamma, otworzyło nową dziedzinę astronomii wieloaspektowej i pozwoliło rozwiązać m. in. problem pochodzenia rozbłysków gamma.

W odkryciach mają istotny wkład uczeni z polskiego zespołu Polgraw wchodzącego w skład międzynarodowej współpracy Ligo-Virgo-Kagra.

W ramach wykładu opowiem o przełomowych odkryciach astrofizyki fal grawitacyjnych, o źródłach fal grawitacyjnych, wyjaśnię jak fale grawitacyjne oddziałują z materią, jakiego typu informacje możemy uzyskać obserwując Wszechświat w falach grawitacyjnych oraz o przyszłych eksperymentach.

Speaker: Dorota Gondek-Rosińska (Obserwatorium Astronomiczne UW) -

09:40

Kosmiczny Chłód 35m

Czy wszechświat wypełniony miliardami gorących gwiazd może być naprawdę chłodny. Czy w tak zimną przestrzeń trzeba wysyłać lodówki? Czy astronautom zmarzną palce gdy zdejmą rękawiczki w kosmosie? Na chłodno ale z emocjami rozważymy te i kilka dodatkowych pytań.

Speaker: Damian Jabłeka (Planetarium i Obserwatorium Astronomiczne im. Mikołaja Kopernika w Chorzowie) -

10:20

Edukacja Kosmiczna: Inspiracje i wyzwania w szkole i klasie 20m

W dobie rosnącego zainteresowania tematyką kosmiczną, edukacja kosmiczna staje się kluczowym elementem kształcenia młodego pokolenia. W wykładzie wezmą udział Ambasadorki Edukacji Kosmicznej ESERO Polska, które zaprezentują innowacyjne metody wprowadzenia tematyki kosmicznej do programu nauczania. Uczestnicy dowiedzą się, jak realizować edukację kosmiczną w praktyce, omówią wyzwania stojące przed Europejską Agencją Kosmiczną (ESA) oraz zaprezentują różnorodne scenariusze zajęć, które mogą wzbogacić lekcje. W drugiej części wykładu poruszymy temat astronautyki analogowej, przedstawiając, jak można stać się astronautką w symulowanych warunkach. Ten wykład ma na celu zainspirowanie nauczycieli i uczniów do odkrywania tajemnic kosmosu oraz zaangażowanie ich w fascynujący świat nauki i technologii.

Speakers: Agnieszka Winiarska -Furtak (Szkoła Podstawowa nr 1 w Rumi) , Joanna Grecka-Otremba (Zespół Szkół i Placówek nr 1 w Katowicach / Pałac Młodzieży w Katowicach)

-

09:00

-

09:00

→

18:40

Wystawa sponsorów i prezentacja ofert studiów dla szkół i studentów Hol

Hol

-

11:00

→

11:20

Przerwa 20m

-

11:20

→

12:50

Wykłady plenarne B.1.1+B.0.38+B.0.39 (połączone)

B.1.1+B.0.38+B.0.39 (połączone)

-

11:20

Zastosowanie gier kwantowych do problemów optymalizacyjnych 25m

W wystąpieniu omówiona zostanie koncepcja równowag Nasha w strategiach czystych kwantowych rozszerzeń klasycznej gry Dylemat Więźnia. Proces kwantowania w schemacie EWL, który został zastosowany, polega na wprowadzeniu dwóch dodatkowych strategii unitarnych, które rozszerzają przestrzeń strategii klasycznej gry. W szczególności rozważone zostaną dopuszczalne klasy takich rozszerzeń, które pozostają niezmiennicze względem izomorficznych przekształceń gry klasycznej. Uzyskane równowagi Nasha wykazują lepszą zbieżność z rozwiązaniami Pareto-optymalnymi niż równowagi Nasha w klasycznym ujęciu gry. Wyniki te ukazują złożoność i różnorodność zachowań strategicznych w kontekście kwantowym, dostarczając nowych perspektyw w analizie klasycznych dylematów decyzyjnych. W ostatniej części wystąpienia omówione zostaną wybrane aplikacje w przemyśle.

Speakers: Anna Gorczyca-Goraj (Department of Operations Research, University of Economics in Katowice, ul. Bogucicka 3, 40-287 Katowice, Poland) , Marek Szopa (Department of Operations Research, University of Economics in Katowice, ul. Bogucicka 3, 40-287 Katowice, Poland) -

11:50

Jak uczyć, żeby dotrzeć 30m

Przychodzimy na świat z naturalną ciekawością i wewnętrzną motywacją [1-3], które napędzają nieustanną eksplorację świata we wczesnym dzieciństwie – radość z odkrywania i motywację do poszukiwania odpowiedzi na nieznane. W obecnych czasach, w sytuacji szybkich i gwałtownych zmian cywilizacyjnych, jak nigdy wcześniej, istnieje potrzeba utrzymania i rozwijania tej naturalnej dociekliwości uczennic i uczniów w całym toku ich edukacji, wobec konieczności przygotowania ich na życiowe i zawodowe wyzwania, które być może nawet nie zostały jeszcze zidentyfikowane.

Obecny format edukacji, z przeładowanymi programami nauczania i, wynikającym z nich, głównie podawczym przekazem informacji, nie jest w stanie sprostać wyzwaniom rozwijającego się świata, gdyż tłumi naturalną ciekawość uczennic i uczniów i nie rozwija w nich w wystarczającym stopniu krytycznego podejścia do życiowych doświadczeń oraz radzenia sobie w nieznanych sytuacjach. Pojawia się zatem paląca potrzeba zmiany wizji edukacji, w odpowiedzi na pytanie – jaki powinien być jej cel, gdzie chcemy dotrzeć?

Badania pokazują, że przyswajanie dużej ilości wiedzy w krótkim czasie wpływa negatywnie na jej retencję i motywację do nauki. Nie adresuje także rozwoju kompetencji uczennic i uczniów, rozumianych jako połączenie wiedzy, umiejętności i postaw. Naturalna dociekliwość uczennic i uczniów, aby się rozwijać, potrzebuje edukacji dociekającej, opartej na metodach aktywizujących różne obszary mózgu, w tym na współpracy w grupie. Jednak taka zmiana w podejściu do kształcenia, oprócz reform systemowych, wymaga wsparcia transformacji samych nauczycieli i nie jest możliwa bez rozwoju ich własnych kompetencji i umiejętności dociekania.

References

[1] M.P. Carlton and A.Winsler, “Fostering Intrinsic Motivation in Early Childhood Classrooms”. In: Early Childhood Education Journal 25 (1998), pp. 159–166. doi: 10.1023/A:1025601110383

[2] R. M. Ryan, and E. L. Deci, “Intrinsic and Extrinsic Motivations: Classic Definitions and

New Directions”. In: Contemporary Educational Psychology, 25 (2000), pp.54–67. doi:10.1006/ceps.1999.1020

[3] P.E. Shah, H.M. Weeks, B. Richards, N. Kaciroti. “Early childhood curiosity and kindergarten reading and math academic achievement”. In: Pediatric Research, 84 (2018), pp.380-386. doi.org/10.1038/s41390-018-0039-3Speaker: Dagmara Sokołowska (Smoluchowski Institute of Physics, Jagiellonian University, Lojasiewicza 11, 30-348, Krakow, Poland) -

12:20

Sekcja Dydaktyki Fizyki PTF 20m

Wychodząc naprzeciw oczekiwaniom polskich dydaktyków fizyki od styczniu 2025 roku działa w ramach Polskiego Towarzystwa Fizycznego Sekcja Dydaktyki Fizyki licząca już prawie 100 członków reprezentujących wszystkie poziomy edukacyjne włączając w to również dydaktykę akademicką.

Zadaniem każdej sekcji jest realizowanie celów PTF w zakresie spraw objętych wspólnymi zainteresowaniami naukowymi lub wspólnym charakterem pracy zawodowej jej członków. W związku z powyższym Sekcja Dydaktyki Fizyki swoją aktywność wiąże z badaniami naukowymi w obrębie dydaktyki fizyki (w tym dydaktyki szczegółowej - metodyki nauczania fizyki), a także z popularyzacją fizyki.

Członkowie Sekcji podjęli w ostatnim półroczu szereg działań mających na celu szeroko pojęte wsparcie metodyczne. Utworzona została strona internetowa zawierająca bazę istotnych dla pracy dydaktycznej informacji. W założeniu baza ta będzie przy udziale członków Sekcji nadal sukcesywnie uzupełniana. Zarząd Sekcji przesyła jej Członkom cyklicznie informacje na temat związanych z dydaktyką fizyki ważnych wydarzeń. W ramach Sekcji powołany został też Rzecznik prasowy, którego zadaniem jest przygotowywanie miesięcznych raportów do newsletter-a PTF. Członkowie Sekcji tworzą już pierwsze zespoły robocze.

W roku szkolnym i akademickim 2025/2026 planowane są też webinaria i wykłady otwarte, zaś we wrześniu 2026 roku pod patronatem Sekcji Dydaktyki Fizyki odbędzie się w Warszawie 4 Kongres Nauczycieli Fizyki.

Badania w zakresie metodyki nauczania fizyki to sprawa niezwykle ważna dla współczesnego społeczeństwa. Rzeczywistość w jakiej żyją dziś młodzi ludzie jest inna niż ta, w której dorastali ich nauczyciele i wykładowcy. Dla nich dopływ nowych informacji nie kończy się po wyjściu ze szkoły, czy z uczelni. Zreformować należy więc nie tylko programy nauczania, ale całą metodologię nauczania fizyki. Oznacza to, że potrzeba nam pilnie nowych specjalistów – metodyków fizyki, którzy podjęliby się tego zadania, a przy okazji mogliby się rozwijać naukowo.

Zadanie to może być zrealizowane jednak tylko wtedy, gdy dydaktyka fizyki potraktowana zostanie jako dyscyplina naukowa, a ośrodki naukowe w Polsce umożliwią dydaktykom zdobywanie tytułów naukowych doktora oraz doktora habilitowanego. Problem braku możliwości rozwoju naukowego dydaktyków fizyki podejmowany był już wielokrotnie podczas kolejnych Zjazdów Fizyków Polskich – niestety bez pozytywnych skutków. Nie oznacza to jednak, że należy zrezygnować ze starań – trzeba je wręcz zintensyfikować.

Jednym z głównych zadań Sekcji Dydaktyki Fizyki jest reprezentowanie interesów polskich dydaktyków fizyki na wszystkich możliwych płaszczyznach, a sprawa rozwoju naukowego dydaktyków stanowi w tej kwestii priorytet. Wyrazić należy bowiem obawy, że jeśli problem nie zostanie na czas rozwiązany w niedalekiej przyszłości zabraknie metodyków, a co za tym idzie zabraknie dobrze metodycznie wykształconych nauczycieli fizyki. Następstwem będzie zamykanie w liceach oddziałów z rozszerzonym programem nauczania fizyki (co już niestety ma miejsce), drastyczny spadek abiturientów wybierających fizykę na egzaminie maturalnym (tylko w roku 2024 liczba osób wybierających fizykę na maturze spadła o prawie 3000!) i w konsekwencji spadek liczby kandydatów na studia techniczne i fizyczne oraz niski poziom tych, którzy te studia wybiorą. Najwyższa więc pora by zadbać o dobry fundament polskiej fizyki i włączyć rozwojowi naukowemu dydaktyków zielone światło.Speaker: Aneta Mika (XIV Liceum Ogólnokształcące z Oddziałami Dwujęzycznymi w Szczecinie) -

12:40

InnoFusion 2025: Rozdanie nagród 10m

-

11:20

-

12:50

→

14:00

Przerwa obiadowa 1h 10m

-

14:00

→

16:00

Infrastruktura badawcza B.1.1

B.1.1

-

14:00

Od neutronów do światła - NCBJ buduje naukową przyszłość. PolFEL - nowy gracz na naukowej mapie Europy. 30m

Narodowe Centrum Badań Jądrowych w Świerku od lat kojarzone jest w Polsce przede wszystkim z reaktorem MARIA – jedynym tego typu obiektem w naszym kraju. To właśnie dzięki niemu NCBJ odgrywa kluczową rolę w produkcji izotopów dla medycyny, prowadzi zaawansowane badania materiałowe i jest obecne na naukowej mapie świata.

Dziś jednak w NCBJ powstaje nowe, równie unikatowe urządzenie – PolFEL, pierwszy w Polsce laser na swobodnych elektronach (Free Electron Laser, FEL). To nowoczesne źródło światła pozwoli generować intensywne i ultrakrótkie impulsy w niezwykle szerokim zakresie – od promieniowania terahercowego i podczerwieni, poprzez światło widzialne, aż po nadfiolet próżniowy (VUV). Dzięki temu możliwe będzie prowadzenie badań w nanoskali i ultrakrótkich czasach, otwierających drogę do przełomowych odkryć w biologii, chemii, fizyce materiałów i technologiach przyszłości.

PolFEL stanie się nowym symbolem potencjału NCBJ – podobnie jak reaktor MARIA – czyniąc ze Świerku ośrodek wyjątkowy w skali Europy, łączący tradycję badań jądrowych z najnowocześniejszymi technologiami laserowymi.Speaker: Katarzyna Nowakowska-Langier (Departament Infrastruktury Badawczej Narodowe Centrum Badań Jądrowych ych) -

14:30

ILL and ESS – Key Neutron Sources for Scientific Research 30m

Neutron sources constitute a unique research tool, particularly valuable in studies of the structure and dynamics of condensed matter, as well as in chemistry, biology, materials science and life sciences. Currently, the two most important European centres of this kind are the Institut Laue–Langevin (ILL) in Grenoble and the emerging European Spallation Source (ESS) in Lund. For more than five decades, ILL has provided access to a high-flux research reactor, forming the basis for many breakthrough studies, including those on high-temperature superconductivity, novel magnetic phases, structural biology and natural sciences. ESS, as the world’s most advanced spallation source, will in the coming years offer new experimental opportunities – in neutron spectroscopy and diffraction, studies of functional materials, life sciences, as well as processes occurring on time scales from picoseconds to microseconds.

The Polish scientific community mainly uses the instruments available at ILL and is gradually preparing for future utilisation of the ESS infrastructure. A key challenge for the coming years is to strengthen the involvement of Polish research teams and to make more effective use of these instruments so that both facilities can better support research carried out in our country.

Speaker: Ewa Juszyńska-Gałązka (Instytut Fizyki Jądrowej im. Henryka Niewodniczańskiego Polskiej Akademii Nauk) -

15:00

Research opportunities at SOLARIS synchrotron 30m

The SOLARIS synchrotron in Krakow is a third-generation light source operating at 1.5 GeV electron energy. The first synchrotron light from SOLARIS was observed in 2016, while the first user experiments were performed in 2018 using soft X-ray absorption spectroscopy and angle resolved photoelectron spectroscopy beamlines. Since, SOLARIS is expanding its activities, developing new end-stations and providing complementary infrastructure such as cryo-electron microscopes [1]. The experimental techniques offered by SOLARIS, the only synchrotron in Central-Eastern Europe, can well complement the outcomes of Mossbauer spectroscopy and hyperfine methods in basic and applied interdisciplinary research projects.

It should be emphasized that access to the research infrastructure at SOLARIS is free of charge and provided based on the assessment of the beamtime applications by the international review panel. Financial support to user visits is provided through EU projects NEPHEWS, ReMade@ARI, and RIANA as well as CERIC-ERIC consortium.Acknowledgments

We acknowledge the entire team of SOLARIS Centre and the supporting research groups. SOLARIS operation is financed by Polish Ministry and Higher Education project: “Support for research and development with the use of research infrastructure of the National Synchrotron Radiation Centre SOLARIS” under contract nr 1/SOL/2021/2.

[1] J. Szlachetko, J. Szade M. Stankiewicz, et al., Eur. Phys. J. Plus 138 (2023) 10.Speaker: Jakub Szlachetko (SOLARIS National Synchrotron Radiation Facility, Jagiellonian University) -

15:30

Europejskie Centrum Promieniowania Synchrotronowego 30m

Europejskie Centrum Promieniowania Synchrotronowego (European Synchrotron Radiation Facility - ESRF) jest międzynarodową infrastrukturą badawczą zlokalizowaną w Grenoble we Francji, po raz pierwszy udostępnioną użytkownikom w 1994 roku. Laboratorium zostało wybudowane, jest utrzymywane oraz modernizowane dzięki współpracy krajów tworzących Konsorcjum ESRF. Obecnie w skład Konsorcjum wchodzi 19 krajów: Francja, Niemcy, Włochy, Wielka Brytania, Rosja, Hiszpania, Szwajcaria, Konsorcjum BENESYNC składające się z Belgii i Holandii, Konsorcjum NORDSYNC składające się z Danii, Finlandii, Norwegii i Szwecji oraz kraje stowarzyszone (wkład do budżetu poniżej 4%) czyli Austria, Izrael, Polska, Portugalia, Czechy oraz Republika Południowej Afryki.

ESRF oferuje użytkownikom czas pomiarowy na 46 liniach badawczych, które zostały podzielone na 6 grup tematycznych: „Structural biology”, „Structure of materials”, „Electronic structure, magnetism & dynamics”, „Matter at extremes”, „Complex systems & biomedical sciences” oraz “X-ray nanoprobe”. Oferowane techniki obejmują m.in.: dyfrakcję, rozpraszanie, obrazowanie, spektroskopię absorpcyjną i emisyjną, krystalografię molekularną, spektroskopię UV-VIS, dichroizm magnetyczny.

Czas pomiarowy w ESRF przeznaczony jest przede wszystkim dla naukowców z krajów wnoszących wkład do budżetu ESRF. Projekty indywidualne zbierane są dwa razy w roku, do 1 marca oraz do 10 września i oceniane przez Naukowe Komitety Recenzujące na podstawie ich wartości naukowej. Ostateczna decyzja o wyborze projektów do realizacji zależy od technicznych możliwości wykonania projektu oraz uwzględnia wykorzystania przez dany kraj należnego czasu badawczego.

Dostęp do wiązki polskim naukowcom zapewnia grant Ministerstwa Nauki i Szkolnictwa Wyższego pt. "Polski wkład do Europejskiego Centrum Promieniowania Synchrotronowego" (UMOWA Nr 2021/WK/11), który finansuje 1% wkładu do ESRF. Oferuje on również dofinansowanie uczestnictwa w konferencjach dla naukowców z polską afiliacją prezentujących wyniki badań przeprowadzonych w ESRF. Regulamin dofinansowania zamieszczony jest na stronie projektu: http://www.ifpan.edu.pl/esrf/.

Speaker: Anna Wolska (Instytut Fizyki PAN)

-

14:00

-

14:00

→

17:40

Sesja dydaktyczna/naukowa V B.0.39

B.0.39

-

14:00

Nowoczesna dydaktyka fizyki, oparta o doświadczenia wykonywane z użyciem urządzeń cyfrowych 25m

Wystąpienie będzie serią doświadczeń ułożonych w pokaz wykorzystania technologii cyfrowej do skutecznego nauczania fizyki w szkołach podstawowych i średnich.

Urządzenia komputerowe i smartfony są obecnie jednym z bardziej znaczących sposobów poznawania świata przez współczesną młodzież. Nowoczesna dydaktyka nie powinna pomijać tego faktu, a może wykorzystać go przy budowaniu motywacji uczniów do nauki oraz integrowania różnych dziedzin wchodzących w skład STEM.

Na przykład, obserwacja w czasie rzeczywistym zmian prostych wielkości fizycznych uczy nawet najmłodsze dzieci intuicji potrzebnych przy odczytywaniu i tworzeniu wykresów, a to przydaje się nie tylko na lekcjach matematyki, ale także w wielu innych sytuacjach wymagających interpretacji wyników eksperymentów przyrodniczych.

Technologia cyfrowa pozwala bardzo szybko przygotować i wykonać doświadczenia w klasie, a szerokie spektrum możliwości przedstawienia wyników w sposób poglądowy ułatwia uczniom zrozumienie i zapamiętanie praw fizyki.

Ze względów dydaktycznych niektóre doświadczenia powinny zostać wykonane w sposób tradycyjny, by uczniowie w pełni zrozumieli istotę zjawiska. Warto jednak, by nauczyciel – nie poświęcając na to zbyt wiele czasu – zaprezentował uczniom przykład współczesnych metod pomiarowych. Przyczyni się to do poszerzenia horyzontów edukacyjnych młodzieży i powiązania fizyki z innymi dziedzinami STEM. Bardzo często jest to możliwe dysponując prostymi czujnikami cyfrowymi zaprojektowanymi do celów edukacyjnych.

Stosowanie technik doświadczalnych opracowanych w XIX lub na początku XX wieku nie jest dobrym sposobem nauczania współczesnej młodzieży, od której przyszli pracodawcy będą oczekiwać nie tylko wiedzy i umiejętności przedmiotowych, ale także powiązania ich z technologią cyfrową i elementami inżynierii. Eksperymenty, które zostaną zaprezentowane odpowiadają wyzwaniu nauczania w skuteczny sposób tego, co uczniom najbardziej potrzebne.Speaker: Tomasz Sobiepan (Image Recording Solutions Sp. z o.o.) -

14:25

Potencjał Centrum SOLARIS w popularyzacji nauki: Akademia Skilla jako innowacyjny model edukacji 25m

Narodowe Centrum Promieniowania Synchrotronowego SOLARIS Uniwersytetu Jagiellońskiego to unikalna infrastruktura badawcza w Polsce, oferująca szerokie możliwości nie tylko dla naukowców, ale również w przestrzeni edukacji i popularyzacji nauki. SOLARIS stanowi miejsce prowadzenia zaawansowanych badań w dziedzinie fizyki, chemii, biologii i nauk stosowanych, ale także jest swoistym centrum edukacji, w którym można doświadczyć nauki w sposób interaktywny i angażujący. Narodowe Centrum od dwóch lat organizuje oprowadzanie po swojej infrastrukturze badawczej, oferując zwiedzającym możliwość poznania technologii synchrotronowej i kriomikroskopowej, ich zastosowań oraz znaczenia dla rozwoju nauki i przemysłu. Uczestnicy wycieczek mogą zobaczyć na żywo synchrotron i jego kluczowe elementy, dowiedzieć się, jak powstaje i wykorzystywane jest promieniowanie synchrotronowe, a także jak przyczynia się ono do przełomowych odkryć w medycynie, inżynierii czy ochronie dziedzictwa kulturowego.

Akademia Skilla to dwuletni projekt edukacyjny (2024-2026) realizowany przez Narodowe Centrum Promieniowania Synchrotronowego SOLARIS, w ramach grantu SON II, finansowanego z Ministerstwa Nauki i Szkolnictwa Wyższego. Projekt łączy naukę z praktyką, wykorzystując zaawansowaną infrastrukturę badawczą synchrotronu i laboratorium kriomikroskopii. Jego celem jest popularyzacja nauk ścisłych, rozwijanie pasji do badań naukowych oraz inspirowanie młodych umysłów do budowania kariery dziedzinach o wysokiej specjalizacji, a także zakorzenienie postawy cechującej nadrzędną rolę nauki w procesie globalnego rozwoju cywilizacyjnego.

W ramach przedsięwzięcia skierowanego do nauczycieli i uczniów, przewidziano oprowadzanie po Centrum SOLARIS, podczas którego uczestnicy mogą poznać funkcjonowanie akceleratorów oraz metody badawcze wykorzystujące promieniowanie synchrotronowe. Kluczowym elementem projektu jest opracowanie i wdrożenie innowacyjnej gry edukacyjnej, która w przystępny sposób tłumaczy złożone zagadnienia naukowe i stanowi atrakcyjne narzędzie dydaktyczne dla uczniów i nauczycieli.

Dzięki wykorzystaniu nowoczesnych multimedialnych form, takich jak audioprzewodniki i ekrany haptyczne, Akademia Skilla umożliwia uczestnikom zdobywanie praktycznych umiejętności z zakresu badań naukowych i technologii akceleratorowych. Program wzbogaca dydaktykę poprzez interaktywne formy nauki, rozwijając krytyczne myślenie, umiejętność pracy zespołowej oraz inspirując młodych ludzi do dalszej eksploracji świata nauki i technologii.Wystąpienie przedstawi potencjał Narodowego Centrum SOLARIS jako przestrzeni popularyzacji nauki, omawiając rolę Akademii Skilla w budowaniu świadomości naukowej oraz inspirowaniu młodych ludzi do eksploracji świata fizyki i inżynierii. W szczególności zostanie zaprezentowana koncepcja innowacyjnej gry dydaktycznej oraz sposoby jej implementacji w edukacji formalnej i nieformalnej.

Speaker: Agnieszka Cudek (SOLARIS National Synchroton Radiation Centre, Jagiellonian University) -

14:50

Inwestycja w Przyszłość. Wspólna droga szkół i uniwersytetów 25m

Każdy etap rozwoju młodego człowieka — aż do osiągnięcia dorosłości — kształtowany jest przez wiedzę i doświadczenia zdobywane na kolejnych poziomach edukacji. Zgodnie z Prawem oświatowym [1], „kształcenie i wychowanie służy rozwijaniu u młodzieży poczucia odpowiedzialności, miłości do Ojczyzny oraz poszanowania dla polskiego dziedzictwa kulturowego, przy jednoczesnym otwarciu się na wartości kultur Europy i świata. Szkoła powinna zapewnić każdemu uczniowi warunki niezbędne do jego rozwoju oraz przygotować go do wypełniania obowiązków rodzinnych i obywatelskich, w oparciu o zasady solidarności, demokracji, tolerancji, sprawiedliwości i wolności”.

Na kolejnych szczeblach kształcenia ujawnia się, że misją szkolnictwa wyższego i nauki jest nie tylko prowadzenie edukacji oraz badań na najwyższym poziomie, ale również kształtowanie postaw obywatelskich oraz aktywny udział w rozwoju społecznym i gospodarczym, opartym na innowacjach [2].